琐碎记录:Go, Redpanda 与 Protobuf

琐碎记录:Go, Redpanda 与 Protobuf

概述

"We can solve any problem by introducing an extra level of indirection."

(没有任何计算机问题是加一层中间层解决不了的。)

— David J. Wheeler

回溯软件开发的“田园时代”,我们面对的往往是一个庞大的单体应用(Monolith)。在这个世界里,所有的功能模块都驻留在同一个进程的地址空间内。模块间的数据交换变得异常直观且高效——只需传递一个指针或引用,数据便能瞬间在函数调用栈之间实现共享。内存,就是天然的通信总线。

然而,随着业务复杂度的熵增,单体架构逐渐显得臃肿且难以维护。我们开始追求更细粒度的解耦,渴望将不同的职责拆分到独立的服务中。更重要的是,我们希望在不同的场景下使用最适合的工具:例如,利用 Go 语言卓越的并发调度能力处理高吞吐的网络请求,同时利用 Python 丰富的生态在 AI 推理领域大展拳脚。这种“多语言编程(Polyglot Programming)”的微服务架构带来了灵活性与可维护性,却也同时也摧毁了我们曾经依赖的“共享内存”。

当服务被物理隔绝在不同的进程甚至不同的服务器上时,我们失去了一条可以直接读取变量的“内存通道”。这就引出了分布式系统中的核心挑战:如何在异构服务之间,重建一套类似于过去内存变量般高效、通用且易于理解的数据交换机制?

为了解决“传输”问题,业界演化出了消息中间件(Message Queue/Streaming Platform)来替代内存总线,在分布式场景下实现异步解耦。但是,解决了管道问题后,我们还需要定义流淌在管道中的“介质”。不同的语言对数据的内存布局理解各异,我们需要一种通用的标准来描述数据结构。

Google Protocol Buffers (Protobuf) 正是这一领域的佼佼者。它提供了一种语言无关、平台无关的可扩展机制,用于序列化结构化数据。如果说消息中间件是分布式系统的神经纤维,那么 Protobuf 就是在其中传递的标准神经信号。

本文旨在整理为了理解一个基于 Go 语言的网关服务所必须要掌握的基本知识。这个 Go 网关负责接收 UDP 协议传输的 Protobuf 数据包,并将这些结构化的数据高效写入到 Redpanda(兼容 Kafka 协议的高性能流数据平台)中。

Protobuf

从文本到二进制的跨越

JSON 与二进制的抉择

在异构系统通信的数据格式选择上,XML 和 JSON 曾统治了很长一段时间。得益于简洁的语法、高可读性以及与 Web 前端天然的契合度,JSON 逐渐取代了 XML,成为 API 设计的事实标准。在配置文件、Web 接口等对可读性要求高于性能的场景下,JSON 无疑是最佳选择。

然而,当我们把视线转向高频交易、实时遥测或大规模微服务网关等对带宽和时延极度敏感的场景时,JSON 的“轻量”就显得有些力不从心了。

让我们通过一个具体的例子来算一笔账。假设我们需要传输一个包含“时间戳”和“100个采样值”的数据包。

如果使用 JSON,结构可能如下所示:

1 | { |

空间成本:文本协议的膨胀

我们需要意识到,JSON 本质上是一种文本格式。这意味着无论是在网络传输还是磁盘存储中,它都是一串字符序列。

这个 JSON 对象的大小计算方式如下: * 结构字符:所有的 {, }, [, ], ", :, , 等符号。 * 字段名称:"timestamp" 和 "values" 的字符占用。 * 数值的文本化:这是最浪费空间的地方。以浮点数 0.1234568 为例,在内存中它只是一个 4 字节的 float32,但在 JSON 中,它变成了 "0.1234568" 这 9 个字符。在 UTF-8(兼容 ASCII)编码下,这占据了 9 个字节。

在这个例子中,所有字符加起来大约需要 1100 字节。

如果我们剥离掉所有的人类可读修饰,直接传输二进制数据呢?

- 时间戳:计算机内部的标准时间通常是 Unix Timestamp(从 1970-01-01 开始流逝的时间)。对于毫秒甚至纳秒级精度,一个

int64(64位整数)足矣。int64的范围约为 \(\pm 9 \times 10^{18}\),即使精确到纳秒,也能覆盖前后约 292 年的跨度,占据 8 字节。 - 采样值:100 个单精度浮点数(float32),在内存中紧凑排列,占据 \(100 \times 4 =\) 400 字节。

总计仅需 408 字节。

对比结果惊人:同等信息量下,JSON 的体积几乎是二进制格式的 2.7 倍。 在海量数据传输的场景下,这意味着带宽成本的成倍增加。

时间成本:编解码的算力陷阱

除了空间膨胀,JSON 在处理速度上也存在天然劣势。为什么 JSON 的序列化(Serialization)和反序列化(Deserialization)会比二进制慢一个数量级?

这主要归咎于文本解析的复杂性:

- 词法与语法分析:计算机读取 JSON 时,必须逐字符扫描,判断哪里是花括号、哪里是逗号、哪里是字符串的结束。这实际上是在运行一个状态机,消耗大量 CPU 周期。

- 数值转换:将字符串

"0.1234568"转换为内存中的浮点数(IEEE 754 标准),涉及到复杂的数学运算(类似于atof或ParseFloat)。反之亦然。 - 内存分配(GC 压力):解析 JSON 往往需要创建大量的临时小对象(如字段名的字符串对象),这在 Go 这样带有垃圾回收(GC)的语言中,会带来额外的 GC 压力。

相比之下,二进制协议的处理极其简单:数据在内存中的布局与传输格式几乎一致。解析过程往往只需要简单的位运算、内存拷贝(memcpy)或类型转换,CPU 指令极度精简,效率极高。

为什么我们需要 Protobuf?

手写二进制封包,例如规定前 8 个字节是时间,后 400 个字节是数组,可以带来极致的带宽和处理速度,但是反过来可能会面临一定的维护挑战:

- 可读性差:抓包看到的全是乱码,无法直接调试。

- 弱版本兼容性:一旦在中间加了一个字段,所有旧版本的程序都会因为偏移量错位而崩溃。

- 跨语言痛点:必须为 Go、Python、C++ 分别手写一套解析逻辑,不仅繁琐,而且极易因大小端(Endianness)或内存对齐问题导致 Bug。

那么是否有一种既拥有二进制的高效,又具备 JSON 般通用性的方案呢?

Google Protocol Buffers (Protobuf) 正是为此而生。

它提供了一套完美的解决方案: 1. Schema 定义:通过 .proto 文件定义数据结构,清晰明确,充当服务间的“契约”。 2. 代码生成:通过 protoc 编译器自动生成 Go、Python、C# 等各种语言的读写代码,屏蔽了底层的字节操作细节。 3. 向后兼容:其巧妙的编码机制(Tag-Length-Value)允许你在不破坏旧服务的情况下增加新字段。 4. 极致性能:虽然比纯粹的 C 结构体稍慢一点(因为包含元数据),但仍远快于 JSON,且体积极小。

Protobuf 定义

概述

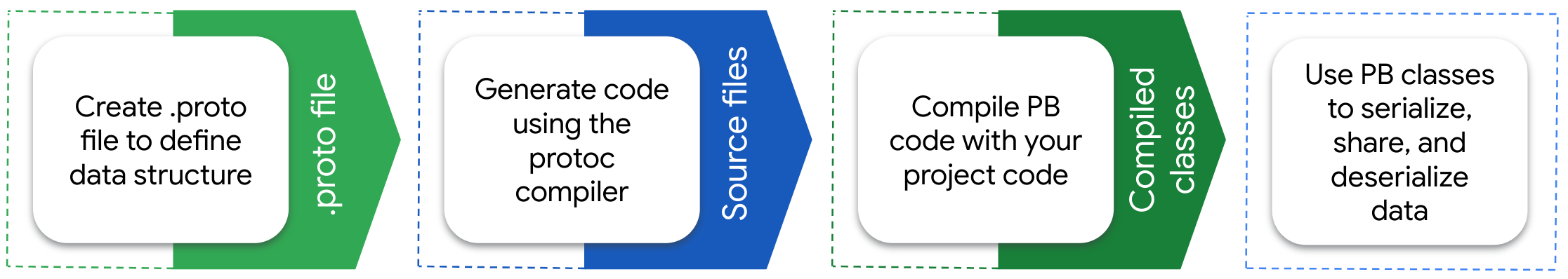

Protobuf 的工作流非常符合工程直觉:定义先行。我们需要创建一个 .proto 文件来描述数据结构(Schema),然后使用 protoc 编译器将其“翻译”成特定编程语言的源码。这些生成的源码包含了类型定义、Getter/Setter 以及最核心的序列化(Marshal)与反序列化(Unmarshal)逻辑。

一个典型的 .proto 文件如下所示:

1 | syntax = "proto3"; // 指定版本,目前主流推荐使用 proto3 |

字段编号:Protobuf 的“身份证”

在定义消息(Message)时,你可能会注意到每个字段后面都有一个数字(= 1, = 2)。这不仅仅是某种默认赋值,而是 Protobuf 最核心的概念:字段编号(Field Number)。

这些编号必须遵循以下规则: * 唯一性:在同一个 Message 内,编号不可重复。 * 保留区:编号 19000 到 19999 是 Protobuf 内部保留的,不可使用。 * 不可变性:一旦你的服务上线,绝对不能更改已存在的字段编号。

为什么必须要有编号?

在 JSON 中,我们依靠字段名(如 "username")来识别数据。但这带来了两个问题:一是字段名本身占用了大量空间;二是如果你想重命名代码里的字段(比如把 username 改为 user_name),会导致旧数据无法解析。

Protobuf 解耦了“代码中的字段名”和“传输中的标识符”。在二进制流中,只有字段编号,没有字段名。这意味着:只要编号不变,你以后可以随意修改字段的名称,完全不影响兼容性。

二进制流编码

在 Protobuf 序列化后的二进制流中,数据是以 Key-Value 对 的形式紧凑排列的。其中,Key 就是 Tag,用来标识字段编号和字段的底层编码格式。

整个二进制流实际上长这样:

1 | <Tag1><Value1><Tag2><Value2><Tag3><Value3>...... |

因为有 Tag,解码器才能知道每个 value 属于哪个字段、该字段如何解析、遇到不认识的字段该怎么跳过。

Protobuf 的 Tag 是一个 varint(可变长整数),由字段号和底层编码格式组合而成: \[ \mathrm{Tag} = (\mathrm{Field\_Number} \ll 3) \mid \mathrm{Wire\_Type} \] 其中:

- Field_Number:在

.proto中写的字段编号(如 1、2、3……) - Wire_Type:字段底层采用的编码格式(varint、32-bit、64-bit、length-delimited 等)

<< 是左移运算符,它会把一个数的二进制整体向左移动,右侧补 0。比如:

10的二进制是1010,左移 3 位:

1 | 1010 << 3 = 1010000 |

1000的二进制是1111101000,左移 3 位:

1 | 1111101000 << 3 = 1111101000000 |

在 Tag 中,字段号左移 3 位,就是给低 3 位空出空间用来存 Wire_Type。| 是 按位 OR(按位或),其用途就是把 Wire Type 塞进 Tag 的低 3 位,同时保留左移后的字段号的高位。本质是把两部分二进制“合并”到一个数字里。

Wire Type

Protobuf 的 .proto 层面有很多类型(int32、int64、string、bytes、float……),但它们最终都归类到极少数几种底层编码方式,也就是 Wire Type。例如:

int32/int64/uint32/bool/enum→ 全部都是 varint(wire type 0)double/fixed64→ 64-bit(wire type 1)string/bytes/message→ length-delimited(wire type 2)float/fixed32→ 32-bit(wire type 5)

也就是说:

.proto 类型多,Wire Type 少。

为什么?因为 Wire Type 描述的是字节布局方式,不是数据意义。

Wire Type 的取值范围是 0–5:

| Wire Type | 值 | 通常对应的编码结构 |

|---|---|---|

| varint | 0 | int32, int64, bool, enum… |

| 64-bit | 1 | fixed64, double |

| length-delimited | 2 | string, bytes, embedded message |

| start group(废弃) | 3 | 不再使用 |

| end group(废弃) | 4 | 不再使用 |

| 32-bit | 5 | fixed32, float |

3 bit 可以表示 0–7,共 8 种,足够覆盖所有 Wire Type。

Varint Type

Protobuf 中的大多数整数类型(int32 / int64 / uint32 / uint64 / sint32 / sint64 / bool / enum)都使用叫做 Varint(可变长度整数)的编码方式。这是 Protobuf 能保持小体积的核心武器。Varint 的意义是数值越小,占用字节越少。

Varint 会把一个整数按 7 位一组进行编码:

- 每 7 位被打包成一个字节

- 字节的最高位(MSB)作为“继续标志”

1xxxxxxx→ 后面还有字节0xxxxxxx→ 最后一个字节

这意味着:

| 数值范围 | Varint 占用字节 |

|---|---|

| 0–127 | 1 字节 |

| 128–16,383 | 2 字节 |

| 16,384–2,097,151 | 3 字节 |

| … | 最多 10 字节(对应 int64) |

我们可以举个例子,现实中,一个 Unix 时间戳大多是 1e9 ~ 1e12。所以在 Protobuf 中存储通常只需要 5~8 字节,小于固定 8 字节的传统 64 位整数。也就是说:

int64 在 Protobuf 中不是固定 8 字节,而是根据实际数值大小自动缩减到 5~8 字节左右。

为什么 Protobuf 必须要存 Tag 和 Wire Type?

如果没有 Tag,Protobuf 就没法做到它最强的特性:前后兼容性(Back/Forward Compatibility)。例如:

1 | message User { |

版本 2 增加字段:

1 | message User { |

有 Tag 和 Wire Type 的话:老客户端 自动跳过 它不认识的字段,新客户端 自动使用默认值 补齐缺少的字段。没有 Tag,这种灵活性完全做不到。

而如果没有 Wire Type,解码器就没法跳过未知字段了。Wire Type 让解码器知道“当前字段占多少字节”,因此可以跳过:

- varint → 一直读到 MSB=0

- length-delimited → 先读长度,再跳过后续 N 字节

- 32-bit → 跳 4 字节

- 64-bit → 跳 8 字节

这是 Protobuf 能稳定运行的关键。

存储优化

首先,因为 Tag 本身也需要占用空间,所以我们有如下优化策略:

- 1 到 15 的编号:Tag 仅占 1 字节。应预留给最频繁使用的字段。

- 16 到 2047 的编号:Tag 占用 2 字节。

另外,我们可以回过去看看我们之前的例子:1 个 int64 时间戳 + 100 个 float32 浮点数。

方案 A:101 个独立字段

1 | message BadDesign { |

让我们算一笔账: 1. 数据本身:8 字节 (时间) + 100 \(\times\) 4 字节 (浮点数) = 408 字节。 2. Tag 开销: * 字段 1-15(共 15 个):每个 Tag 1 字节 \(\rightarrow\) 15 字节。 * 字段 16-101(共 86 个):每个 Tag 2 字节 \(\rightarrow\) 172 字节。 * 额外开销总计:187 字节。

总大小 \(\approx\) 595 字节。相比纯裸数据的 408 字节,膨胀了约 45%。

方案 B:Repeated 数组

Protobuf 提供了 repeated 关键字来表示数组。更重要的是,在 proto3 中,对于数字类型的数组,默认启用 Packed Encoding(打包编码)。

1 | message GoodDesign { |

在这种模式下,100 个浮点数不再需要 100 个 Tag,而是共享同一个 Tag,数据紧挨着存放:

[Tag 2] [Length=400] [Value1][Value2]...[Value100]

现在的账单是: 1. 时间戳:Tag(1 byte) + Data(Varint 编码后约 6 bytes) = 7 字节。 2. 数组:Tag(1 byte) + Length(2 bytes) + Data(400 bytes) = 403 字节。

总大小 \(\approx\) 410 字节。这仅比理论最小值的 408 字节多了 2 个字节!这便是 Protobuf 在处理数组时极致高效的原因。

编译与使用

定义好 .proto 文件后,我们使用 protoc 进行编译。

安装编译器(以 MacOS 为例):

1 | brew install protobuf |

编译命令:

1 | # 生成 Go 代码 |

生成的代码使得我们可以像操作本地对象一样操作二进制数据:

Go 语言示例

1 | // 创建对象 |

Python 示例

1 | import your_data_pb2 |

C# 示例

1 | using Google.Protobuf; |

这种跨语言的一致性体验,正是我们在构建异构微服务或网关时的核心诉求。

Go

项目组织

在 Go 语言的设计哲学中,代码的组织结构不仅仅是文件的摆放位置,更决定了代码的可见性、依赖关系和编译方式。理解 Module(模块) > Package(包) > File(文件) 这一层级结构,是构建健壮 Go 应用的基石。

标准项目布局

虽然 Go 官方没有强制规定目录结构,但社区已经形成了一套广泛认可的“标准布局”(Standard Go Project Layout)。一个典型的 Go 项目通常长这样:

1 | myapp/ |

关键目录解析:

cmd/:这里存放项目的入口。如果你的项目包含多个组件(比如一个 API Server,一个 Worker,一个 CLI 工具),你应该在cmd/下建立对应的子目录(如cmd/api、cmd/worker)。internal/:这是 Go 语言中一个特殊的目录。Go 编译器强制规定:internal目录下的包,只能被其父级目录(及其子目录)下的代码 import。这是一种强有力的访问控制机制,用于隐藏那些不希望被外部项目依赖的内部实现细节。pkg/:按照惯例,这里存放那些设计良好、可以被外部项目(其他 Module)安全引用的通用库代码。- 注:随着现代 Go 开发习惯的演进,很多项目倾向于将大部分业务逻辑放在

internal中,只有明确需要开源共享的才放进pkg,甚至完全省略pkg目录。

- 注:随着现代 Go 开发习惯的演进,很多项目倾向于将大部分业务逻辑放在

Module:依赖管理的边界

Module(模块) 是代码版本控制和依赖管理的基本单位。项目的根目录下必须包含一个 go.mod 文件。

1 | module github.com/me/myapp // 1. 定义模块路径(即项目的 Import Path 前缀) |

这意味着,你项目中的所有包,其 Import 路径都将以 github.com/me/myapp/ 开头。

Package:编译与引用的核心

Package(包) 是 Go 源码组织与编译的最小单位。关于 Package,有三个必须厘清的核心概念:

A. 目录即包 (Directory is Package)

除了 main 包外,同一个目录下的所有 .go 文件必须属于同一个包。

Go 的设计哲学是:用 Package 做边界,不用文件做边界。

这意味着:

- 文件无边界:同一目录(Package)下的不同

.go文件,在编译时会被合并视为一个整体。 - 内部互通:在

a.go中定义的未导出变量(小写开头),在同目录的b.go中可以直接使用,无需 import。在 Go 语言中,不存在“文件级私有”的概念。

B. Import 路径 ≠ Package 名称

这是初学者最容易混淆的地方。

- Import 路径:指的是包在文件系统(或网络)中的位置。

- Package 名称:指的是你在代码声明中写的

package xxx,即在代码中使用的标识符。

让我们看一个具体的例子:

假设文件路径为:internal/biz/calculator/math.go,文件内容如下:

1 | // 文件路径:internal/biz/calculator/math.go |

当你在 main.go 中使用它时:

1 | package main |

虽然通常建议目录名与包名保持一致以减少困惑,但在技术上它们是可以解耦的。

C. 可见性控制:大小写定乾坤

Go 摒弃了 public、private、protected 等复杂的关键字,采用了一种极简的命名约定来控制可见性(Exported/Unexported):

- 首字母大写 (Upper Case):已导出 (Exported)。相当于 Public,可以被外部包访问。

- 例如:

fmt.Println、math.Pi、user.ID。

- 例如:

- 首字母小写 (Lower Case):未导出 (Unexported)。相当于 Private,仅在当前包(Package)内部可见。

- 例如:

var version string、func helper()。

- 例如:

这种设计使得代码的访问权限一目了然——你只需要看一眼标识符的名字,就知道它能不能被外部调用,而无需查看定义处的关键字。

Go 的运行图景:结构体、接口与生命周期

类与结构体:形散而神似

Go 语言中没有 class 关键字,但它依然具备面向对象编程(OOP)的核心能力:封装。Go 选择了一种更原始但也更灵活的方式——结构体(Struct) + 方法(Method)。

在 C# 或 Java 中,数据和行为是天然绑定在 class 里的:

1 | // C# |

而在 Go 中,数据(struct)和行为(func)在语法上是分离的,通过接收者(Receiver) 将它们关联起来:

1 | // Go |

这种模式本质上就是面向对象。UserService 是类,s 是实例(this 指针)。不同的是,Go 摒弃了继承(Inheritance),全面拥抱组合(Composition)。如果想要复用代码,直接把一个结构体嵌入到另一个结构体中即可。

入口函数:手动挡的“依赖注入”

编译型语言的运行逻辑大同小异:一个入口函数作为线头,串起整个世界。

在 C# 或 Spring Boot 中,我们习惯依赖庞大的 DI 容器(如 AutoFac, Spring IOC)来自动扫描并注册服务。而在 Go 社区,我们更倾向于“显式优于隐式”。在 main.go 中,通常采用手动的方式进行服务的初始化和依赖注入(Wiring)。这看起来原始,但带来了极致的清晰度——你完全知道哪个服务依赖了哪个组件。

结合我们 UDP 网关写入 Redpanda 的场景,一个生产级的 main.go 通常包含:配置加载 -> 组件初始化 -> 启动服务 -> 监听信号 -> 优雅退出。

1 | package main |

接口:隐式契约与“鸭子类型”

在没有继承的世界里,接口(Interface) 是实现多态和依赖倒置的唯一途径。

Go 的接口设计非常独特,它采用的是 结构化类型系统(Structural Typing),俗称“鸭子类型”(Duck Typing):

"If it looks like a duck, swims like a duck, and quacks like a duck, then it probably is a duck."

规则很简单:一个类型只要实现了接口中定义的所有方法,它就自动实现了该接口。 不需要 implements 关键字,不需要显式声明。

接口定义

Go 的接口通常非常小,往往只包含 1 到 2 个方法。命名惯例是以 -er 结尾:

1 | // 定义一个可以处理数据的接口 |

隐式实现示例

假设我们有两个完全不相关的结构体,只要它们都有 Handle 方法,它们就是 DataHandler:

1 | // 1. Redpanda 生产者 |

这种设计使得 Go 的组件极其容易解耦。你可以在写 UDP Server 时只定义一个 Writer 接口,在单元测试时传入一个假的 MockWriter,而在生产环境传入真实的 RedpandaWriter。

关键细节:指针接收者 vs 值接收者

在实现接口时,Go 初学者最容易遇到的坑就是 方法接收者(Receiver) 的类型选择。

定义方法时,你可以选择将方法挂载到 值(Value) 上,还是挂载到 指针(Pointer) 上。这不仅关乎性能和可变性,更关乎接口的实现判定。

| 形式 | 写法 | 特点 | 接口实现规则 |

|---|---|---|---|

| 值接收者 | func (s User) Name() |

传递结构体的副本。无法修改原结构体数据。 | User 和 *User 都算作实现了该接口。 |

| 指针接收者 | func (s *User) SetName() |

传递指针。可以修改原结构体数据。 | 只有 *User 算作实现了该接口。 |

为什么会有这个区别?

因为 *User(指针)总是能解引用拿到 User(值),所以值方法对指针也有效。但反过来,一个纯粹的 User(值)可能是在不可寻址的内存区域(比如临时变量),或者出于语义考虑(不可变对象),编译器不会自动把它转成指针传给修改方法。

最佳实践: 1. 如果方法需要修改结构体的内容,必须用指针接收者。 2. 如果结构体很大(包含大量数据),为了避免拷贝开销,建议用指针接收者。 3. 如果不确定,那就用指针接收者。 4. 如果你定义了任何一个指针方法,建议把该结构体的所有方法都统一定义为指针接收者,保持一致性。

代码示例:

1 | type Counter interface { |

Go 语言速成

在 AI 辅助编程的时代,学习一门新语言的范式已经发生了改变。我们不再需要背诵厚厚的语法手册,只要掌握了语言的骨架(Project Layout)、核心特性(Concurrency) 以及一些反直觉的语法细节(Quirks),配合 AI 工具,我们就能迅速投入到业务开发中。对于这类“边干边学”的开发者,理解以下 Go 语言的特性至关重要。

1. 语法:打破肌肉记忆

Go 的语法设计极度崇尚“显式”和“简洁”,这可能会让你在一开始感到不适应。

类型后置:变量名在前,类型在后。这更符合人类语言的阅读习惯(“定义一个变量

count,它是int”)。1

2

3

4

5

6var c, python, java bool

// 连续参数类型相同时,只需写最后那个

func swap(x, y string) (string, string) {

return y, x

}拒绝隐式转换:Go 没有 C++ 或 Java 那种隐式的数值提升。

int32和int64是完全不同的类型,必须显式转换,否则编译器会直接报错。这是为了杜绝精度溢出带来的隐患。1

2var i int = 42

var f float64 = float64(i) // 必须显式转换短变量声明

:=:这是 Go 代码中最常见的符号。它只能在函数内部使用,用于声明并初始化变量(自动推导类型)。1

2

3func main() {

k := 3 // 简写,等同于 var k int = 3

}

2. 控制流:少即是多

Go 只有一种循环关键字:for。它既是 for,也是 while。

三段式(标准):

1

for i := 0; i < 10; i++ { sum += i }

While 模式(省略前后):

1

for sum < 1000 { sum += sum }

死循环(常用于守护进程或网络监听):

1

2

3for {

// 持续接收连接

}

“带初始化的 If” 是 Go 的一大特色。你可以在判断条件前执行一段简短语句,该语句定义的变量作用域仅限于 if 代码块内。这在处理错误时极其常用:

1 | // 尝试启动服务,如果有错,err 变量只在这个 block 里有效 |

3. 资源管理:Defer 机制

defer 是 Go 优雅处理资源释放的神器。它将函数推迟到当前外层函数返回前执行。

- 执行顺序:后进先出(LIFO/栈)。

- 应用场景:文件关闭、锁释放、网络断开、日志落盘。

比如,在高性能日志库(如 Zap)中,日志通常是先写入内存缓冲区的(Buffered IO)。defer logger.Sync() 确保了程序退出前,缓冲区里的日志被强制刷入硬盘,避免日志丢失。

1 | func main() { |

4. 内存模型:指针与值传递

这是从 Python/Java 转过来的开发者最容易混淆的地方。

- Python: 变量名是对象的引用。修改对象属性会影响全局。

- C#: 有引用类型和值类型之分,类、数组、委托等默认是引用类型。

- Go: 永远是值传递(Pass by Value)。

如果你把一个结构体传给函数,Go 会把整个结构体的内容拷贝一份。如果你想修改外部的数据,或者结构体很大(避免拷贝开销),你必须传递指针。

1 | type Person struct { Name string } |

5. 动态数组:Slice 与 Make

在网络编程(如处理 TCP/UDP 包)时,我们不需要手动管理内存分配,但也无法使用定长数组。这时就需要 Slice(切片)。

切片是对底层数组的一个“视图”,包含指针、长度(len)和容量(cap)。我们使用 make 来初始化它。

场景:UDP 数据接收缓冲

1 | // 创建一个长度为 1024 字节的切片,底层分配了内存,初始值为 0 |

6. 并发哲学:Goroutine 与 Channel

这是 Go 的杀手锏。

Goroutine (Go 程):

极度轻量级的线程。启动一个 OS 线程可能需要几 MB 内存,而启动一个 Goroutine 只需要 2 KB。因此,我们可以轻松启动成千上万个 Goroutine。

1 | go processData(data) // 瞬间启动,不阻塞主线程 |

Channel (信道):

如果在多线程环境下共享内存(比如全局变量),你需要复杂的锁(Mutex)来防止竞争。Go 提出了一个不同的哲学:

"Don't communicate by sharing memory; share memory by communicating."

(不要通过共享内存来通信,而要通过通信来共享内存。)

Channel 就是那个“通信管道”。

- 无缓冲信道:

make(chan int)。同步的,发送方发了,必须等接收方收了,才能继续(握手)。 - 有缓冲信道:

make(chan int, 100)。异步的,只要缓冲区没满,发送方发完就走;只要不空,接收方就有得拿。

Select:多路复用

select 类似于网络编程里的 IO 多路复用,但它是用于 Channel 的。它允许一个 Goroutine 同时等待多个 Channel。

典型场景:优雅退出

在网关开发中,我们经常需要在一个死循环中接收数据,同时又能响应“停止”信号。

1 | func worker(dataCh chan []byte, doneCh chan struct{}) { |

通过掌握这些核心概念,你已经具备了阅读和修改绝大多数 Go 业务代码的能力。剩下的细节,就交给 IDE 和 AI 吧。

流存储:Kafka 与 Redpanda

当我们的 Go 网关将 Protobuf 数据打包好之后,下一步就是将其发送到数据管道中。在这个领域,Apache Kafka 是当之无愧的工业标准,而 Redpanda 则是近年来异军突起的“性能怪兽”。

吞吐量的数量级飞跃

Kafka 及其兼容者本质上是一个分布式流处理平台。与传统的 UDP 应用或普通消息队列(如 RabbitMQ)相比,它们的吞吐量完全不在一个量级:

- Kafka (JVM based): 单节点写入可达 500 MB/s 至 1 GB/s。

- Redpanda (C++ based): 得益于 Thread-per-core 架构和无 GC 设计,单机吞吐轻松突破 10 GB/s。

这种恐怖的 IO 能力,使得它们能够充当整个系统架构的“中枢神经”,缓冲海量实时数据而不发生阻塞。

核心架构:Broker, Topic 与 Partition

理解 Kafka/Redpanda 的关键,在于理解其独特的三层架构:Broker(物理节点)、Topic(逻辑分类)与 Partition(物理存储/并行单元)。

Broker:集群的“算力单元”

Broker 就是运行 Kafka 或 Redpanda 服务的服务器节点。 * 它负责接收生产者的写入请求(Write)、持久化存储数据、以及处理消费者的读取请求(Read)。 * 在一个集群中,多个 Broker 协同工作。就像 CPU 的多个核心一样,Broker 越多,集群的并发处理能力越强。

Topic:逻辑上的“邮箱”

Topic 是一个逻辑概念,用于对消息进行分类。 * 例如,我们将 telemetry 数据发往 raw.telemetry.AC001,将日志数据发往 sys.logs。 * 对于生产者和消费者而言,Topic 是唯一的寻址标识。

Partition:物理上的“分片”

这是 Kafka 高并发的秘诀。Topic 只是一个逻辑外壳,真正存储数据的是 Partition(分区)。

- 分治思想:一个 Topic 可以被切分成多个 Partition(如 Partition 0, 1, 2)。

- 物理存储:在 Broker 的磁盘上,每个 Partition 对应一个append-only 的日志文件序列。

- 例如:

/var/lib/redpanda/data/raw.telemetry.AC001/0/

- 例如:

- 并行度:Partition 决定了并行的上限。3 个 Partition 意味着同一时刻最多支持 3 个消费者并行消费(在一个消费组内)。

配置规则:

- 创建 Topic 时指定 Partition 数量(如

--partitions 4)。 - Partition 数量只能增加,不能减少(这涉及到数据的哈希重分布问题)。

- 系统会自动将这些 Partition 均匀分散在不同的 Broker 上以实现负载均衡。

连接机制:Metadata Discovery

很多初学者会疑惑:“我的集群有 100 台 Broker,难道我在代码里要写 100 个 IP 吗?”

答案是不需要。你只需要配置 Bootstrap Servers(引导节点)。

连接流程如下:

初始连接:Producer 连接你配置的任意一个或几个 Broker(即 Bootstrap Servers)。

元数据请求 (Metadata Request):Producer 自动询问:“请告诉我整个集群的地图。”

获取全景图:Broker 返回集群元数据,包含所有 Topic、Partition 的分布以及它们现在的 Leader 在哪台机器上。

1

2

3

4

5

6

7{

"brokers": [

{"id": 1, "host": "192.168.1.10"},

{"id": 2, "host": "192.168.1.11"}

],

"partitions": {"raw.data": {0: "Broker1", 1: "Broker2"}}

}直连 Leader:Producer 根据这份地图,直接与持有目标 Partition 的 Broker 建立 TCP 连接进行数据传输。

Python 示例

由于 Redpanda 100% 兼容 Kafka 协议,我们直接使用通用的 Kafka 客户端库即可操作。以下代码展示了其极简的 API 设计。

Producer:序列化与发送

Kafka 是二进制协议,它不关心载荷(Payload)是 JSON、XML 还是 Protobuf,它只认 Bytes。因此,发送前必须进行序列化。

1 | from kafka import KafkaProducer |

Consumer:消费组与 Offset

Consumer 的设计引入了 Consumer Group(消费组) 的概念,这是实现“发布-订阅”和“点对点”模型统一的关键。

核心机制:

- Group ID:标识一组消费者。

- 负载均衡:一个 Topic 的 N 条消息,会被均匀分发给同一个 Group 内的消费者。

- 如果有 2 个 Partition,Group 内有 2 个 Consumer,则每人消费 1 个 Partition。

- 原则:同一个 Partition 在同一时刻只能被组内的一个 Consumer 消费。

- Offset(偏移量):Kafka 自动记录每个 Group 在每个 Partition 上读到了哪里。

1 | from kafka import KafkaConsumer |

关键参数:auto_offset_reset

这个参数经常让开发者困惑,它仅在 Kafka 找不到该 Group 的 Offset 记录时(通常是第一次启动该组)生效。

earliest:从 Partition 的第一条消息开始读(重头再来)。适用于离线分析、数据回放。latest(默认):只读启动之后新到达的消息(既往不咎)。适用于实时监控。

注意:一旦消费者成功提交了 Offset,下次重启时,无论这个参数设置什么,Kafka 都会严格按照上次提交的位置继续消费,实现断点续传。

小结

回顾开篇,我们提出了一个核心问题:当单体应用崩塌为微服务,当进程被物理隔绝,我们如何重建那条曾经极其高效的“内存总线”?这篇博客正是为了回答这个问题,勾勒出了这幅技术拼图的三个关键板块:

Protobuf 是“通用的语言”:

它摒弃了 JSON 的臃肿与松散,以紧凑的二进制格式和严格的 Schema(契约),在异构系统之间重建了类似于“强类型变量”的确定性。它是数据在分布式系统中流动的标准形态。

Redpanda/Kafka 是“无限的管道”:

它们超越了传统消息队列的范畴,作为分布式的提交日志(Commit Log),提供了惊人的吞吐量与持久化能力。Topic 和 Partition 的设计,让我们能够像处理本地流一样处理海量数据,实现了服务间的时空解耦。

Go 语言是“高效的搬运工”:

得益于其独特的 Struct(数据)+ Interface(行为) 的组合模式,以及 Goroutine + Channel 的并发哲学,Go 成为了连接上述两者的最佳胶水。它没有繁重的运行时包袱,却能以极低的资源成本,轻松吞吐成千上万的并发请求。

“编写代码”本身往往只是最后的实现步骤,开头的挑战在于理解这些组件背后的设计图像。

当我们理解了 Protobuf 的编码原理,就不会盲目设计冗余的字段;当我们理解了 Kafka 的 Partition 机制,就能设计出更合理的消费模型;当我们理解了 Go 的内存模型与接口隐喻,就能写出真正健壮、清晰的代码。

掌握了这幅全景图,无论你接下来是要构建一个物联网接入网关,还是一个实时日志分析系统,本质上都只是这套逻辑的变体与延伸。希望这篇博客能为你进入高性能后端开发的世界,提供一张清晰的导航图。